脳を観察して心はどこまで解明できるか

玄関に、ちいさな茶色いサンダルがあるなぁと思ってよく見たら、大きなゴキブリだったってこと、よくありますよね。

(ねぇーよ!)

人が物を見て、「これは〇〇だ」と認識するとき、脳の中ではどのように処理されているのでしょう?

脳の神経細胞には、直線を見た時、その角度に応じて反応する神経細胞があります。

水平線だけに反応する細胞、垂直な線だけに反応する細胞、45°の線だけに反応する細胞など、どの角度を認識するか、細胞によって分担されています。

角度のような単純な形だけでなく、動物の顔にのみ反応する細胞などもわかっています。

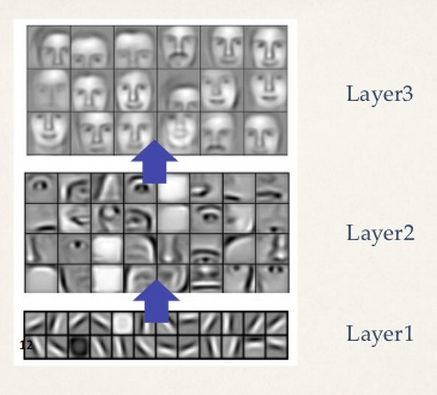

このことから、人は物を見た時、線の角度といった細かい部分から、顔の形といった大きな部分へと、段階的に認識していることがわかります。これは、ディープラーニングでの画像認識と同じです。

「ディープラーニングの限界」で説明したように、ディープラーニングでは、多段階のニューラルネットワークで構成されていて、最初の階層で認識するのは、線の傾きや、丸や四角などの細かい部分で、それが次第に目や耳の形となり、最後の段階で、顔などの全体を認識しています。

このことから、ディープラーニングは、人間が脳の中で処理しているのときわめて近い処理をしているといえます。

近年、このディープラーニングに特化したAIチップが登場して注目されています。

そこで、このAIチップと人間の脳とを比べながら、脳の神経細胞を解明することによって、どこまで意識や心が解明できるかについて考えてみます。

まずは、一般的なコンピュータについて説明します。

コンピュータの種類は、構造によって大きく二つにわけられます。

一つは、一般的なPCに搭載されるCPUであるノイマン型アーキテクチャのコンピュータです。

特徴は、プログラムによって動作することです。

CPUは、足し算回路や掛け算回路など、多数の演算回路を持っていて、プログラムに従って演算を順に実行します。

たとえば、「(1+2)×4」という計算をするには、CPUの足し算回路を使って「1+2」を実行し、その結果の「3」を記憶し、次に、CPUの掛け算回路を使って「3×4」を実行します。

もう1種類のコンピュータは、非ノイマン型アーキテクチャのコンピュータです。

たとえば画像処理を専用に行うGPUなどが、これにあたります。

画像のエンコード、デコード処理では、足し算と掛け算を、何百回、何千回と繰り返して行う必要があります。

これをCPUを使ってプログラムで計算することも可能ですが、同じような計算を、何度もCPUで計算するのは非常に効率が悪いのです。

そのような場合は、専用の演算回路を作った方が効率がいいのです。

つまり、足し算回路と掛け算回路を必要なだけ直列に接続した回路を作るわけです。

すると、1回で、何百回、何千回の足し算、掛け算を行うことができ、非常に高速に処理ができるようになります。

ディープラーニングの計算も、単純な計算を繰り返し行う必要があるので、CPUを使うより、専用の非ノイマン型コンピュータのチップで行う方が効率がいいということで、AIチップが登場してきました。

現在、AIチップの最大手は、NVIDIAですが、これは、GPUメーカーで有名であるというのも、こういった経緯があるからです。

非ノイマン型コンピュータでは、計算する内容をそのまま、演算回路として配線されているので、ワイヤードロジックとも呼ばれています。

これは、脳内の神経回路と同じといえます。

脳の神経回路の処理内容をすべて解明し、同じ機能のコンピュータチップを作れば、意識や心を持ったコンピュータが実現できるはずです。

このような試みは、既に世界中で行われており、日本でも、ドワンゴなどが中心となって脳の全ての機能をコンピュータで実現する全脳アーキテクチャ(WBAI)といった活動が行われています。

さて、ここからが本題です。

物を見て、それが何かを認識するところまでは、ディープラーニングを使った非ノイマン型のAIチップでできます。

「そもそも意識って何?」で考察したことですが、カエルの場合、お腹がすいているときに、目の前にハエが飛んでいるのを認識すれば、舌を伸ばしてハエを捕まえて食べます。

これは、「ハエを認識する」という認識処理と、「舌を伸ばしてハエを捕まえる」という行動処理をつなげれば実現可能です。

「ハエ」の認識と「ハエを捕まえる」の行動を直結するだけの単純なロジックとなります。

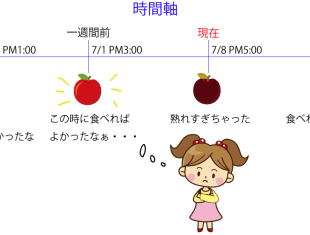

これが人間の場合だと、たとえば「リンゴ」を認識して、「リンゴを今食べようかなぁ」とか、「3時のおやつに食べようかなぁ」などとあれこれ考えることができますが、このようなことは、カエルの脳ではできません。

なぜでしょう?

それは、「ハエ」と認識したあとに、カエルの取り得る行動は、捕まえて食べるか、何もしないかという単純な選択だけだからです。

人間が、「ああしようか、こうしようか」と考えるには、認識した「リンゴ」を頭の中で、あれこれと操作できないといけません。

頭の中で操作するということは、記号処理にあたります。

物をみて、それが何であるか認識する処理、ここまではディープラーニングでできます。

それが何かと認識できれば、それを記号に変換することは可能です。

記号に変換してから、頭の中で「ああしようか、こうしようか」と考えるわけです。

頭の中で「ああしようか、こうしようか」と考えるには、どうすればいいでしょう?

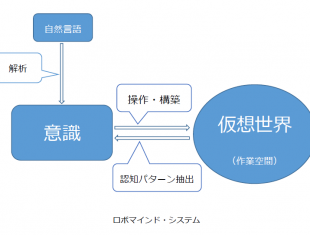

それは、「ロボマインド・プロジェクト システム概要」でも説明したように、仮想世界を構築し、その中で記号を操作する必要があります。

仮想世界とは、人が見たり、感じたりしている現実世界を仮想的に構築した世界です。

「ああしようか、こうしようか」と考えることとは、構築した仮想世界で物事をシミュレーションするといった処理になります。

仮想世界の構築は、ハエを認識して、捕まえるか、捕まえないかだけの二者択一に比べて格段に複雑な処理となります。

ここまで複雑な処理は、非ノイマン型コンピュータでは実行できません。

プログラムを使うノイマン型コンピュータが必要になってきます。

ここからは、僕の仮説ですが、おそらく、人間の脳の構造も、一部はノイマン型アーキテクチャとなっているのではないかと思っています。

つまり、人間の脳は、物を見て、認識するところまでが非ノイマン型アーキテクチャで、物を認識して記号化した後、記号処理の部分がノイマン型アーキテクチャとなっているのです。

非ノイマン型コンピュータの特徴は、とにかく速いことです。

一瞬のうちにハエを認識して、舌を伸ばして捕獲します。

しかし、非ノイマン型コンピュータでは、複雑な処理ができません。

ノイマン型コンピュータだと、シミュレーションのような複雑な処理もできるので、将来の行動をいくつもシミュレーションしたり、過去の出来事を思い出したりすることができます。

「時間は現実には存在しない。時間は幻想。」でも書いたように、時間とは、現在の出来事をエピソード記憶として記憶し、それを後から思い出すとき、過去から現在に流れる「時間」として認識できるのです。

目の前の物体を認識して、それに直結した行動を取ることしかできない動物は、「現在」しか認識できず、過去や未来といった時間は理解できません。

時間といった「概念」を理解するにも、ノイマン型アーキテクチャの脳でないと理解できないのです。

そして、「言葉」です。

動物と人間の一番の違いは、言葉です。

この「言葉」というものは、記号処理に他なりません。

「言葉」を話せるということは、ノイマン型アーキテクチャの構造の脳が必要なのです。

人間と、他の動物とは、一部の脳の構造が根本的に違うと言え、その違いが、ノイマン型アーキテクチャの脳構造を持っているかどうかだと考えられます。

ノイマン型コンピュータの最大の特徴は、プログラムを実行できるということです。

プログラムを入れ替えることによって、あらゆることが可能となります。

ただ、ノイマン型コンピュータの処理を外から観察するだけでは、どのようなプログラムが実行されているか解明することはほとんど不可能です。

CPU内の信号の流れをすべて解明できたとしても、そのCPUで実行されているプログラムが、エクセルか、ワードか、はたまたスーパーマリオブラザーズなのか、プログラムの内容を確定することなど不可能なのです。

非ノイマン型コンピュータなら、処理の内容に沿って演算回路が配置されているので、信号の流れを丹念に追っていけば、どのような処理が行われているのかわかります。

20世紀の終わりごろからの脳科学の発展のおかげで、脳内で物を認識するメカニズムが、かなり解明されてきました。

ただし、その多くは人間特有のものでなく、多くの動物が持ちえる機能です。

人間のみが持ち得る言葉や意識、心のメカニズムに関しては、まだ、ほとんどわかっていません。

その原因は、人間のみが持ち得る機能は、ノイマン型アーキテクチャの脳構造で実現されているのではないのか。

別の見方をすれば、人間は、進化の過程で、ノイマン型アーキテクチャの脳構造を手に入れたのではないのか。

だから、人間のみ、言葉を話せるのではないか、と。

そして、このようなノイマン型アーキテクチャは、外から観察しただけでは、肝心の処理の中身は解明することができません。

脳の中で、主観といったものがどうやって発生するのか(意識のハードプロブレム)、脳をいくら観察しても見えてきません。

意識を持ったAIを実現するには、脳の構造の解明だけでは不十分だと言えます。

意識を持ったAIを実現するには、心のモデルの仮説を作り、それを実際にプログラムで実行して検証するしかないのです。

絶対に超えられないディープラーニング(深層学習)の限界

絶対に超えられないディープラーニング(深層学習)の限界 そもそも意識って何?人工知能で人工意識は作れるの?

そもそも意識って何?人工知能で人工意識は作れるの? ロボマインド・プロジェクト システム概要

ロボマインド・プロジェクト システム概要 時間は現実には存在しない。時間は幻想。

時間は現実には存在しない。時間は幻想。 意識のハードプロブレムが解決しましたが、何か?

意識のハードプロブレムが解決しましたが、何か?